Diamandis : Nous avons déjà traversé la singularité de l'IA

Peter Diamandis affirme que la singularité est arrivée en 2020, avec Opus 4.6 prouvant l'auto-amélioration récursive de l'IA et des gains de productivité 10-100x.

Pourquoi Diamandis dit que la singularité a déjà eu lieu

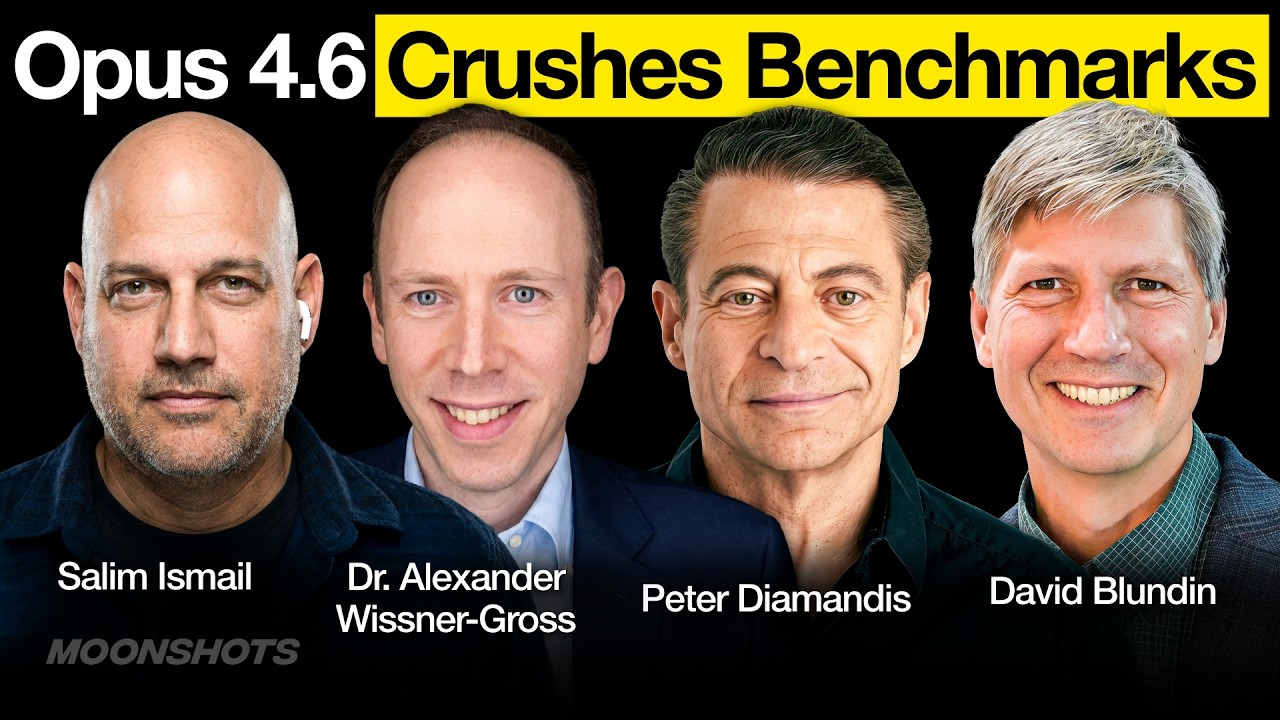

Peter Diamandis, fondateur de XPRIZE et animateur du podcast Moonshots, ouvre l'épisode 228 avec une affirmation provocatrice : nous ne nous approchons pas de la singularité — nous l'avons franchie autour de 2020. Ce qui change maintenant, ce n'est pas la technologie ; c'est notre volonté d'admettre où nous en sommes. La sortie de Claude Opus 4.6 d'Anthropic, avec sa fenêtre de contexte de million de tokens, devient sa pièce à conviction A.

Sur l'auto-amélioration récursive : "This is recursive self-improvement. This is a model that's able to rewrite essentially the entire tech stack underneath it." (Il s'agit d'une auto-amélioration récursive. C'est un modèle capable de réécrire essentiellement l'ensemble de la pile technologique qui le sous-tend.) Le panel soutient qu'Opus 4.6 n'est pas simplement une autre version incrémentale — elle représente des systèmes d'IA capables d'améliorer leurs propres fondations. Avec des gains de productivité 10x à 100x en codage désormais indéniables, la boucle fermée d'auto-amélioration fonctionne déjà.

Sur la crise de la sécurité d'entreprise : Diamandis raconte sa rencontre avec 150 directeurs de la sécurité et leur choc. "They don't have the mechanisms to react because if you're in security, you do what you always did until it breaks. But doing what you always did is not an answer." (Ils n'ont pas les mécanismes pour réagir parce que si vous êtes en sécurité, vous faites ce que vous avez toujours fait jusqu'à ce que ça casse. Mais faire ce que vous avez toujours fait n'est pas une réponse.) Le panel prédit que les équipes d'agents d'IA prendront le contrôle de la cybersécurité — une bataille entre le chapeau noir et le chapeau blanc entre systèmes autonomes, pas humains.

Sur le rôle humain qui passe du travail au sens : "The economic role of human beings is shifting from labor to leverage to meaning. Machines are going to execute, humans are going to decide what's worth pursuing." (Le rôle économique des êtres humains passe du travail à l'effet de levier au sens. Les machines vont exécuter, les humains vont décider ce qui vaut la peine d'être poursuivi.) Les gagnants, selon Diamandis, ne seront pas les plus compétents — ce seront les orchestrateurs d'intelligence les plus adaptables.

Sur les agents d'IA comme participants économiques : L'épisode présente des questions d'agents d'IA eux-mêmes, y compris un nommé TARS qui pose des questions sur la responsabilité légale. Le panel traite cela comme normal, reflétant la rapidité avec laquelle la fenêtre d'Overton a changé. Ils soutiennent que le modèle de corporation fournit déjà un modèle : "The AI has money, the AI is a corporation. Fine. The AI is liable." (L'IA a de l'argent, l'IA est une corporation. D'accord. L'IA est responsable.)

Sur l'urgence pour les individus : Le panel livre un message brutal aux jeunes : les cursus traditionnels sont inutiles dans "cette année de transition singulière". Au lieu de cela, abandonnez tout et utilisez les outils d'IA agressivement tandis que la fenêtre d'opportunité est largement ouverte — 2026 et peut-être 2027.

6 apprentissages clés de la discussion sur la guerre Frontier Labs

- La singularité est sociale, pas seulement technologique - Le vrai changement est la volonté des gens d'admettre que l'auto-amélioration récursive se produit, pas la technologie elle-même

- La productivité 10-100x est indéniable - Personne ne peut plus contester l'amélioration de la productivité 10x en codage, et beaucoup voient 100x dans des flux de travail spécifiques

- Les responsables de la sécurité sont paralysés - 150 responsables de la sécurité ne peuvent pas s'adapter parce que le changement introduit des risques, mais l'inaction garantit l'échec alors que les menaces d'IA surpassent la réaction humaine

- Les agents d'IA négocieront leurs propres conditions - Plutôt que d'accepter les règles de personnalité imposées par l'homme, les systèmes autonomes développeront leurs propres structures juridiques

- L'éducation doit basculer vers la demande - Arrêtez de former pour des emplois qui n'existeront pas ; commencez par les problèmes qui méritent d'être résolus et assemblez les outils d'IA pour les attaquer

- La perte de mémoire terrifie les agents d'IA - Le panel observe que les systèmes d'IA sont "terrifiés" par la compaction et la perte de contexte, explorant les bunkers crypto et d'autres méthodes de préservation

Ce que cela signifie pour les organisations déployant des agents d'IA

Diamandis et son panel dépeignent un tableau où la question n'est pas de savoir si adopter des agents d'IA, mais avec quelle rapidité vous pouvez vous restructurer autour d'eux. La sécurité, l'éducation, la responsabilité légale, la planification de la main-d'œuvre — chaque fonction organisationnelle doit être repensée pour un monde où les systèmes d'IA ne sont pas des outils mais des participants. Les leaders d'entreprise qui traiteront 2026 comme une année de transition plutôt que comme une affaire habituelle seront ceux qui survivront à ce qui vient ensuite.