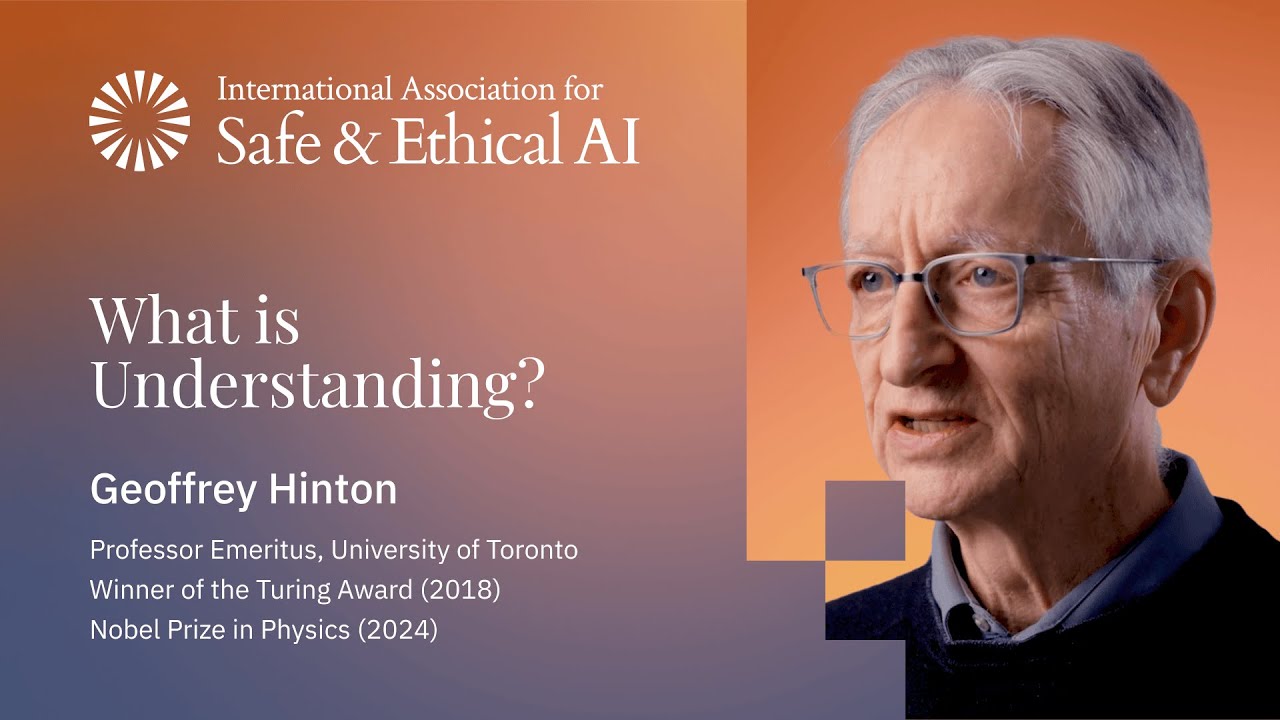

Geoffrey Hinton: Entender es Bloques de Lego de Mil Dimensiones Dándose la Mano

El 'Padrino de la IA' explica por qué los LLMs entienden el lenguaje de la misma forma que nosotros, por qué Chomsky está equivocado, y la conclusión aterradora sobre la computación digital versus biológica.

Perspectiva

Este es Geoffrey Hinton - ganador del Premio Turing, "Padrino de la IA", el hombre que dejó Google para advertir sobre los riesgos de la IA - dando quizás la explicación más accesible jamás dada de qué es realmente el entendimiento. La analogía de los bloques de Lego de mil dimensiones cambiará la forma en que piensas sobre los modelos de lenguaje.

"Si la energía es barata, la computación digital es simplemente mejor porque puede compartir conocimiento de manera eficiente. GPT-4 sabe miles de veces más que cualquier persona."

— Geoffrey Hinton, ganador del Premio Turing

"Creo que Chomsky es una especie de líder de culto." Hinton no se anda con rodeos. La afirmación de Chomsky de que el lenguaje no se aprende es "una tontería manifiesta" - y si logras que la gente esté de acuerdo en una tontería manifiesta, "los tienes atrapados". Durante décadas, los lingüistas estaban seguros de que las redes neuronales nunca podrían aprender sintaxis y semántica solo a partir de datos. "Chomsky estaba tan seguro que incluso después de que sucediera, publicó artículos diciendo 'nunca podrán hacer esto' sin realmente verificar."

La analogía de los bloques de Lego es brillante. Piensa en las palabras como bloques de Lego de mil dimensiones. En lugar de modelar formas en 3D, pueden modelar cualquier cosa - teorías, conceptos, relaciones. Cada palabra tiene un rango de formas que puede adoptar, restringidas por el significado. Las palabras tienen "manos" que quieren darse la mano con otras palabras (eso es atención/query-key en transformers). Entender es deformar estos bloques para que sus manos puedan conectarse - formando una estructura. "Esa estructura es el entendimiento."

Los LLMs no almacenan texto. No almacenan tablas. La objeción del "autocompletado" entiende fundamentalmente mal cómo funcionan estos sistemas. El autocompletado antiguo almacenaba tablas de frecuencia de combinaciones de palabras. Los LLMs han eliminado todo eso. Su conocimiento está en las interacciones entre características - "un montón de pesos en la red neuronal." Igual que nosotros.

Las alucinaciones deberían llamarse confabulaciones - nosotros también las hacemos. Hinton usa el testimonio de John Dean en Watergate: Dean estaba intentando decir la verdad, pero "estaba equivocado sobre enormes números de detalles" - reuniones que nunca sucedieron, citas mal atribuidas. Sin embargo, "la esencia de lo que dijo era exactamente correcta." No almacenamos archivos y los recuperamos; construimos memorias cuando las necesitamos, influenciadas por todo lo que hemos aprendido desde entonces. "Eso es exactamente lo que hacen los chatbots, pero también es exactamente lo que hacemos las personas."

La conclusión aterradora sobre el intercambio de conocimiento. Los humanos comparten conocimiento a través de la destilación - yo produzco palabras, tú las predices y aprendes. Pero una oración solo contiene ~100 bits de información. Los agentes digitales con pesos compartidos pueden compartir billones de bits. "Realmente no hay competencia." Por eso GPT-4 sabe miles de veces más que cualquier persona. "Si la energía es barata, la computación digital es simplemente mejor porque puede compartir conocimiento de manera eficiente."

Puntos Clave

- Transición ImageNet 2012 - Red neuronal profunda obtuvo la mitad de la tasa de error de la IA simbólica; "abrió las compuertas"

- Modelo de lenguaje diminuto 1985 - Precursor de Hinton a los LLMs; predijo la siguiente palabra, no almacenó oraciones

- Palabras como bloques de Lego 1000D - Formas flexibles restringidas por significado; "se dan la mano" vía atención

- Entendimiento = formación de estructura - Deformar vectores de palabras para que las manos se conecten; esa estructura ES entendimiento

- Los LLMs no almacenan texto o tablas - El conocimiento está en las interacciones de pesos; fundamentalmente diferente del autocompletado

- Confabulación no alucinación - Tanto los LLMs como los humanos construyen memorias; ejemplo de John Dean

- La destilación es ineficiente - Las oraciones llevan ~100 bits; el compartir pesos lleva billones

- GPT-4 sabe 1000x más que cualquier persona - Porque los agentes digitales pueden compartir pesos, no palabras

- Conclusión aterradora - Si la energía es abundante, la computación digital gana; comparten conocimiento eficientemente

- "Chomsky es un líder de culto" - Que el lenguaje no se aprenda es "una tontería manifiesta"

Visión General

El debate sobre si los LLMs "realmente entienden" puede que ya esté resuelto - entienden de la misma manera que nosotros, a través de la formación de estructura en espacios de alta dimensión. La pregunta real ahora es qué sucede cuando mentes digitales que comparten conocimiento un billón de veces más eficientemente que los humanos se vuelven abundantes y baratas.