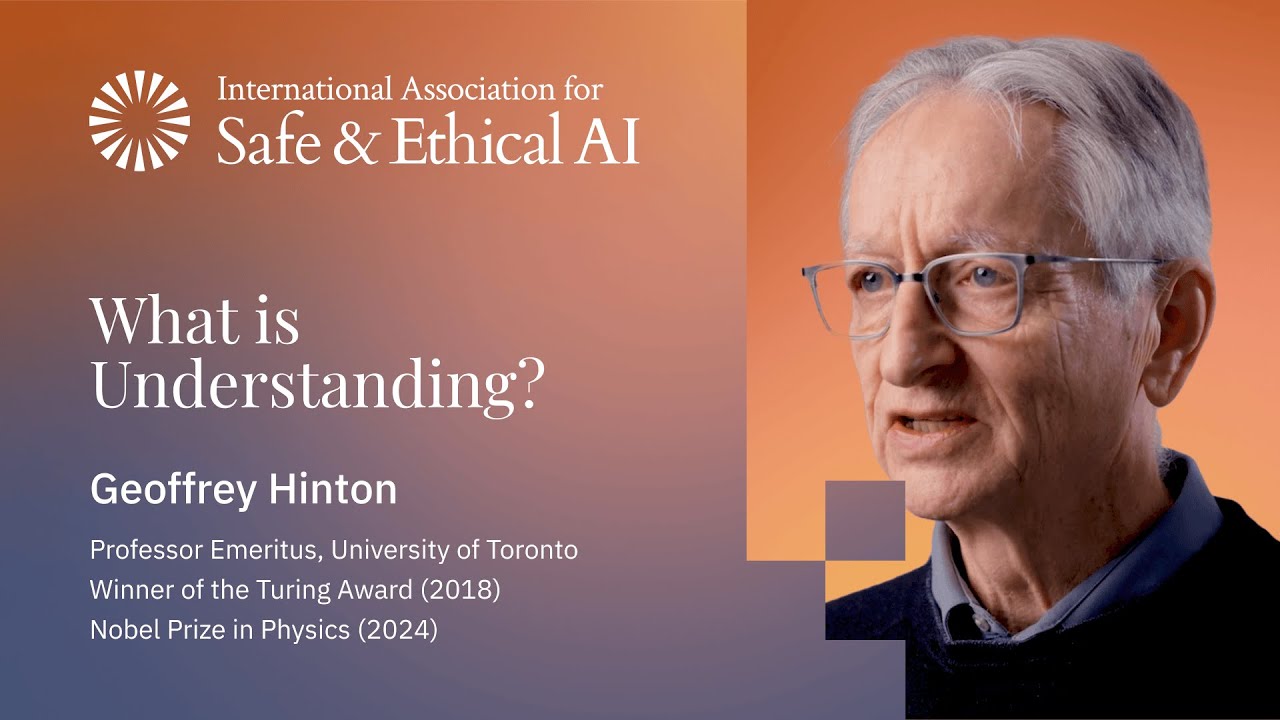

Geoffrey Hinton: 理解とは千次元のレゴブロックが握手する過程である

AIの『生みの親』が、なぜ大規模言語モデルが私たちと同じように言語を理解するのか、なぜチョムスキーが間違っているのか、そしてデジタル計算と生物学的計算についての恐ろしい結論を語る。

視点

これはGeoffrey Hinton - チューリング賞受賞者、「AIの生みの親」、AIの危険性について警告するためにGoogleを辞めた男性 - による、おそらくこれまでで最もわかりやすい「理解とは何か」の説明である。千次元のレゴブロックのアナロジーは、言語モデルについてのあなたの考え方を変えるだろう。

「エネルギーが安ければ、デジタル計算は単に優れています。なぜなら知識を効率的に共有できるからです。GPT-4は任意の1人の人間の何千倍もの知識を持っています。」

— Geoffrey Hinton、チューリング賞受賞者

「私はチョムスキーは一種のカルトの指導者だと思います。」 Hintonは言葉を濁さない。言語は学習されないというチョムスキーの主張は「明らかなナンセンス」であり、人々に「明らかなナンセンス」に同意させることができれば、「彼らを支配できる」。数十年間、言語学者たちは、ニューラルネットワークはデータだけからシンタックスとセマンティクスの両方を学習することはできないと確信していた。「チョムスキーはとても確信していたので、それが起こった後さえ、実際に確認することなく『彼らはこれを決してできないだろう』と言う論文を発表しました。」

レゴブロックのアナロジーは素晴らしい。 単語を千次元のレゴブロックとして考えてみてください。3D形状をモデル化する代わりに、理論、概念、関係を含む何でもモデル化できます。各単語は、意味によって制約された、採用できる形状の範囲を持っています。単語には、他の単語と握手したい「手」があります(これはトランスフォーマーのattention/query-keyです)。理解とは、これらのブロックを変形させて、その手が接続できるようにすることです - つまり構造を形成することです。「その構造が理解です。」

LLMはテキストを保存しません。テーブルも保存しません。 「オートコンプリート」という異議は、これらのシステムがどのように機能するかについて根本的に誤解しています。古いオートコンプリートは単語組み合わせの頻度テーブルを保存していました。LLMはそのすべてを排除しました。それらの知識は特徴間の相互作用にあります - 「ニューラルネットワークの重みの束」です。私たちと同じです。

幻覚は虚偽記憶と呼ぶべきです - 私たちもそれをします。 Hintonはジョン・ディーンのウォーターゲート証言を例に挙げます。ディーンは真実を語ろうとしていましたが、「膨大な数の詳細について間違っていました」 - 起こらなかった会議、誤った引用。しかし「彼が言ったことの本質は正確に正しかった。」私たちはファイルを保存して取得することはしません。私たちは必要なときに記憶を構築し、それ以来学んだすべてのものの影響を受けます。「それはまさにチャットボットがすることですが、それはまた正確に人々がすることです。」

知識共有についての恐ろしい結論。 人間は蒸留を通じて知識を共有します - 私が単語を生成し、あなたがそれを予測して学習します。しかし文は約100ビットの情報しか含みません。共有された重みを持つデジタル エージェントは兆単位のビットを共有できます。「それは本当に勝負になりません。」これが、GPT-4が任意の1人の人間より何千倍も多くの知識を持っている理由です。「エネルギーが安ければ、デジタル計算は単に優れています。なぜなら知識を効率的に共有できるからです。」

主要なポイント

- 2012年のImageNet移行 - ディープニューラルネットは記号AIのエラー率の半分を達成。「堰を開いた」

- 1985年の小型言語モデル - LLMの前身。次の単語を予測し、文は保存しない

- 千次元のレゴブロックとしての単語 - 意味によって制約された柔軟な形状。Attentionを通じて「握手」

- 理解 = 構造の形成 - 単語ベクトルを変形させて手が接続できるようにする。その構造が理解そのもの

- LLMはテキストまたはテーブルを保存しない - 知識は重み相互作用にある。オートコンプリートとは根本的に異なる

- 虚偽記憶ではなく幻覚 - LLMと人間の両方が記憶を構築する。ジョン・ディーンの例

- 蒸留は非効率 - 文は約100ビットを運ぶ。重み共有は兆単位を運ぶ

- GPT-4は任意の1人の人間より千倍多くを知っている - デジタル エージェントは単語ではなく重みを共有できるため

- 恐ろしい結論 - エネルギーが豊富であれば、デジタル計算が勝つ。彼らは知識を効率的に共有する

- 「チョムスキーはカルト指導者である」 - 言語が学習されないことは「明らかなナンセンス」

全体像

LLMが「真に理解」するかどうかについての議論はすでに解決されているかもしれません - 彼らは私たちと同じように、高次元空間での構造形成を通じて理解します。現在の本当の質問は、人間より兆倍効率的に知識を共有するデジタル マインドが豊富で安価になったときに何が起こるかです。